Unseen Style Transfer Based on a Conditional Fast Style Transfer Network

タグ: CNN

概要

Unseen Style Transfer Based on a Conditional Fast Style Transfer Network

- 以前のNeural Style Transferモデルでは、スタイル画像に合わせてモデルの訓練が必要だった

- テスト時に未知のスタイル画像を与えてもスタイル変換可能なモデルを提案

- 複数のスタイル画像に対してスタイル変換を学習した “conditional style transfer network”

- 画像からスタイル情報を抽出する “style condition network”

- これらを組み合わせて任意スタイル画像でのStyleTransferを実現

Conditional Style Transfer Network

- 既存のStyelTransferモデルによる変換済みの画像と元の画像のペアを大量に用意

- 元画像だけでなく、 何番のスタイル画像で変換したペアなのか、を表すベクトル(conditional vector) を入力とし、変換後の画像を生成するようモデルを訓練

- conditional vectorはスタイルの重み付けと見ることができ、$\left( 0.5, 0.5 \right)$ のように複数のスタイルを混ぜることも出来る。

- これにより、 任意のスタイルを学習済みスタイルの線形和によって表現できれば 、任意のスタイル変換を行うことが出来るようになった

Style Condition Network

- 「任意のスタイルを学習済みスタイルの線形和によって表現」 を行うネットワーク

- スタイル画像を入力としconditional vectorを出力する

- Conditional Style Transfer Networkのconditional vectorの入力の代わりにこのモジュールの出力を用いて学習を行う

結果

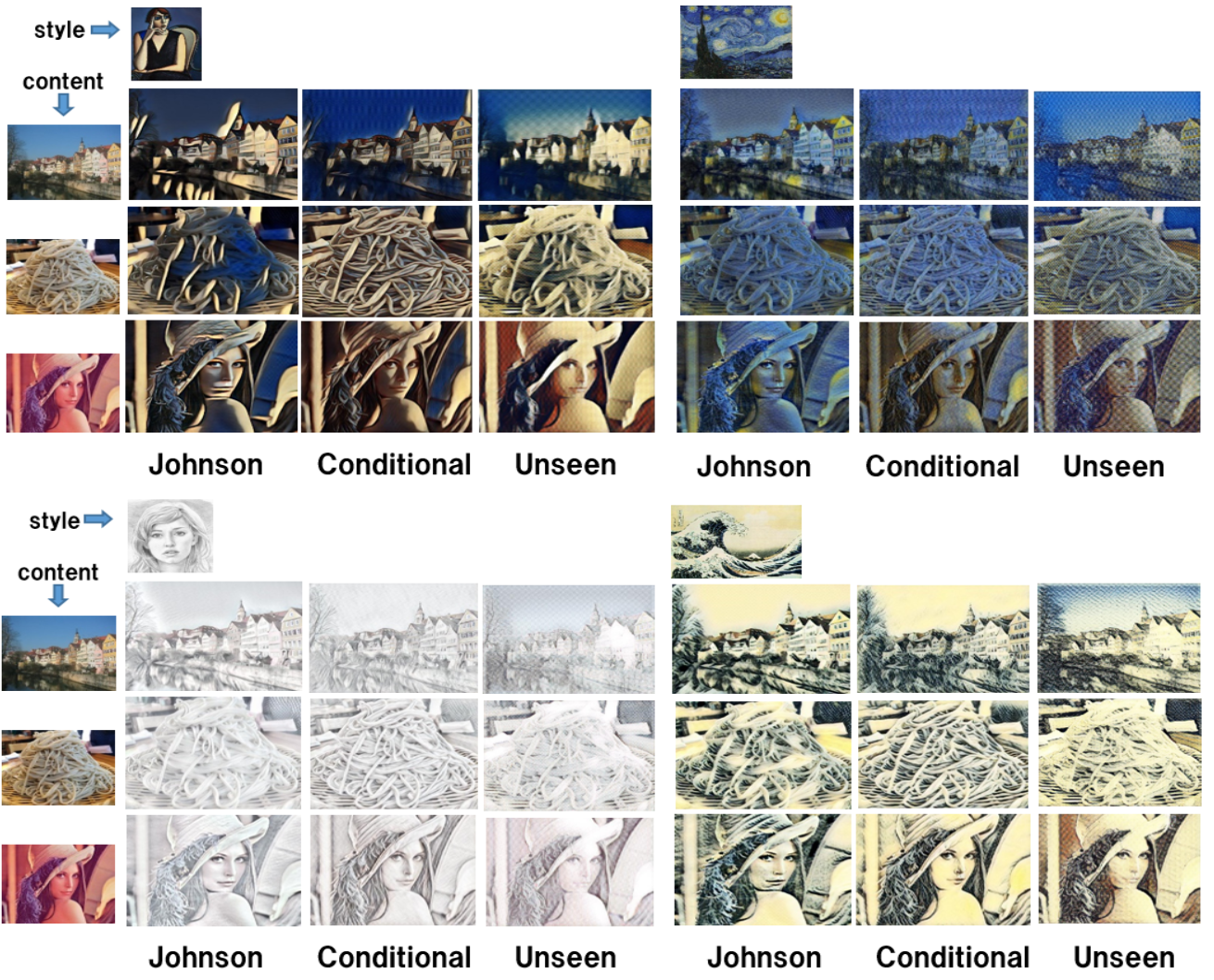

- Jonsonは既存手法

- Conditionalは提案手法かつスタイル画像が既知のもの

- Unseenは提案手法かつスタイル画像が未知のもの

その他

- 著者らが、今回のシステムを用いてリアルタイム画風変換を行うiOSアプリを出している。コードは非公開のようだが、デモ動画によれば330x330の画像を2FPS程度で処理できている。